"L'indexabilité" est un aspect fondamental du référencement naturel. Si vos contenus ne sont pas indexables par les moteurs de recherche, ils ne peuvent pas apparaître dans les résultats de la SERP, ce qui limite considérablement votre visibilité en ligne. Avant de vous concentrer sur l'optimisation de votre contenu, il est crucial de vérifier que vos pages importantes sont bien accessibles pour les robots (dit UserAgent) des moteurs de recherche. Découvrez cette étape cruciale de notre guide technique SEO.

Dans cet article, nous allons passer en revue les méthodes et outils gratuits pour vérifier l'indexabilité de vos pages, en commençant par le fichier robots.txt et en finissant par la vérification des balises noindex.

1. Vérifiez votre fichier robots.txt

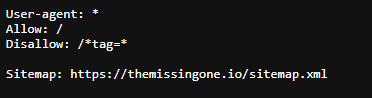

Le fichier robots.txt est l'une des premières choses à vérifier lorsque vous cherchez à savoir si vos contenus sont indexables. Ce fichier, situé à la racine de votre site web, indique aux robots des moteurs de recherche quelles parties de votre site ils sont autorisés ou non à explorer et à indexer. Une mauvaise configuration de ce fichier peut bloquer accidentellement l'accès à des pages importantes pour votre SEO.

Exemple de configuration basique de robots.txt

Pour autoriser tous les robots à accéder à toutes les pages de votre site, le fichier robots.txt doit contenir la configuration suivante :

User-agent: *

Disallow:

Cela signifie que tous les robots sont autorisés à explorer tout le site sans restriction.

Outils et méthodes gratuites pour vérifier votre fichier robots.txt :

Tapez : https://votre-domaine.com/robots.txt dans la barre d'adresse

Vous pouvez facilement accéder à votre fichier par ce biais. Cela vous permet de vérifier son contenu et de vous assurer qu'aucune directive ne bloque l'accès à vos pages importantes.

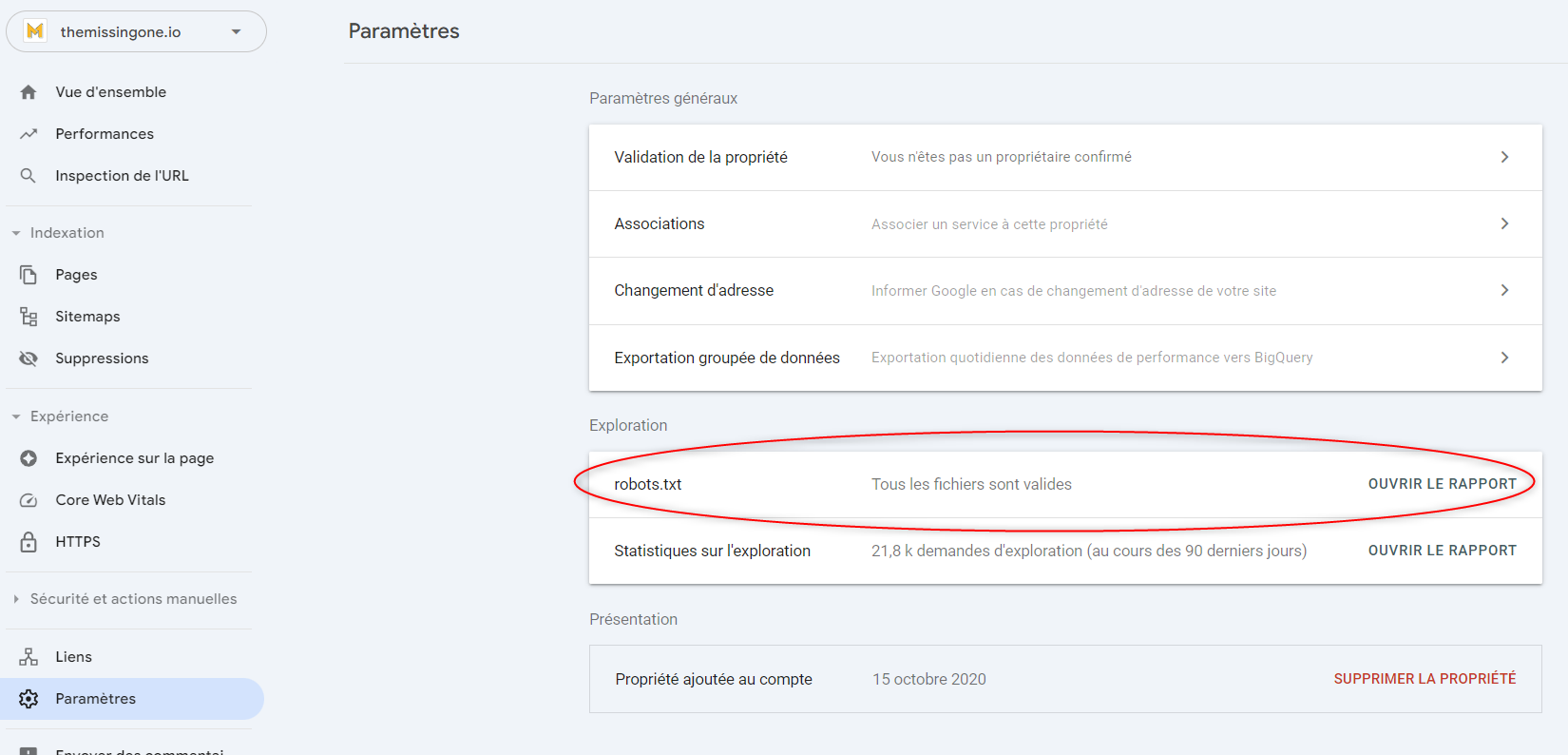

Outil "robots.txt" report de Google Search Console

Google Search Console propose également un outil de test de votre fichier robots.txt. Cet outil vous permet de simuler l'exploration de votre site par les robots et de voir quelles parties du site sont bloquées.Chemin : Paramètres > Exploration > robots.txt > Ouvrir le rapport

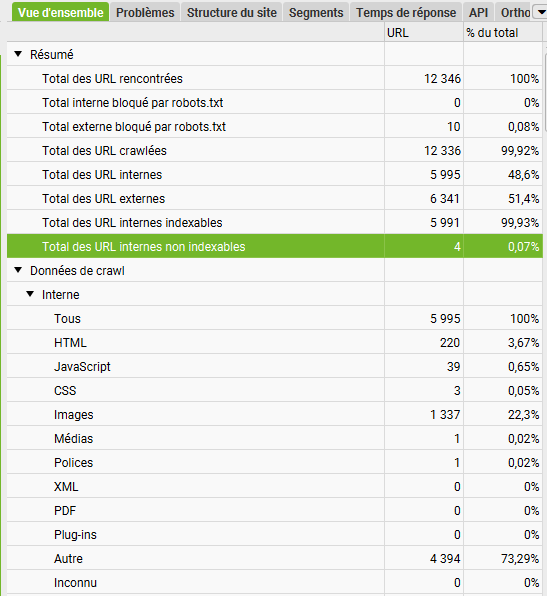

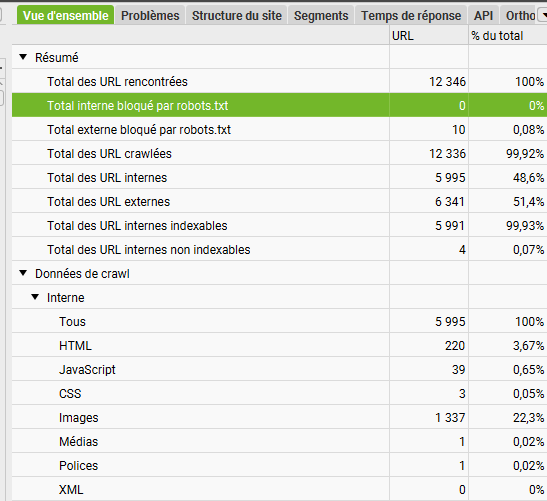

Screaming Frog Spider (mode gratuit)

En mode gratuit, Screaming Frog SEO Spider vous permet de crawler gratuitement jusqu'à 500 pages de votre site, il est ensuite payant. Cet outil est idéal pour vérifier quelles pages sont bloquées par le fichier robots.txt et s'assurer que vos pages essentielles sont accessibles aux robots.

3.Vérifiez les balises html noindex

La balise noindex est une autre méthode utilisée pour empêcher les moteurs de recherche d'indexer certaines pages de votre site. Cette balise est souvent placée dans l'en-tête HTML d'une page pour indiquer aux moteurs de recherche qu'ils ne doivent pas l'ajouter à leur index. Cette balise peut être utile pour les pages que vous ne souhaitez pas voir apparaître dans les résultats de recherche (comme les pages d'administration ou les pages de test), mais elle peut poser problème si elle est accidentellement appliquée à des pages importantes.

Exemple de balise noindex

Voici à quoi ressemble une balise noindex dans le code HTML d'une page :

<!DOCTYPE html>

<html>

<head>

<meta name="robots" content="noindex">

(…)

</head>

<body>(…)</body>

</html>

Si cette balise est présente sur une page importante pour le SEO, elle doit être retirée pour permettre son indexation.

Outils gratuits pour vérifier la présence de la balise noindex

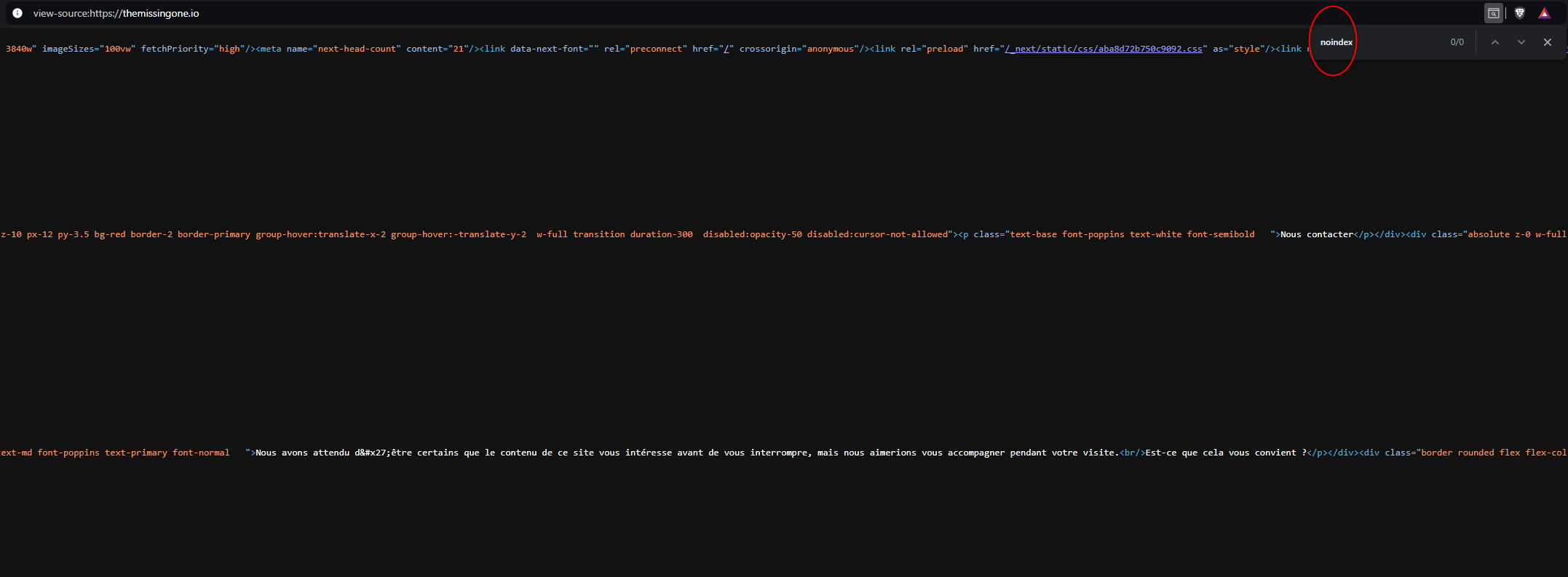

Lire le DOM de votre page web (Ctrl+U puis Ctrl+F)

Une méthode simple pour vérifier la présence d'une balise noindex sur une page consiste à lire le DOM (Document Object Model) de la page en question. Appuyez sur Ctrl+U pour afficher le code source de la page, puis Ctrl+F pour rechercher le mot "noindex". Si la balise est présente, elle apparaîtra dans les résultats de la recherche.

Google Search Console - Inspection d'URL

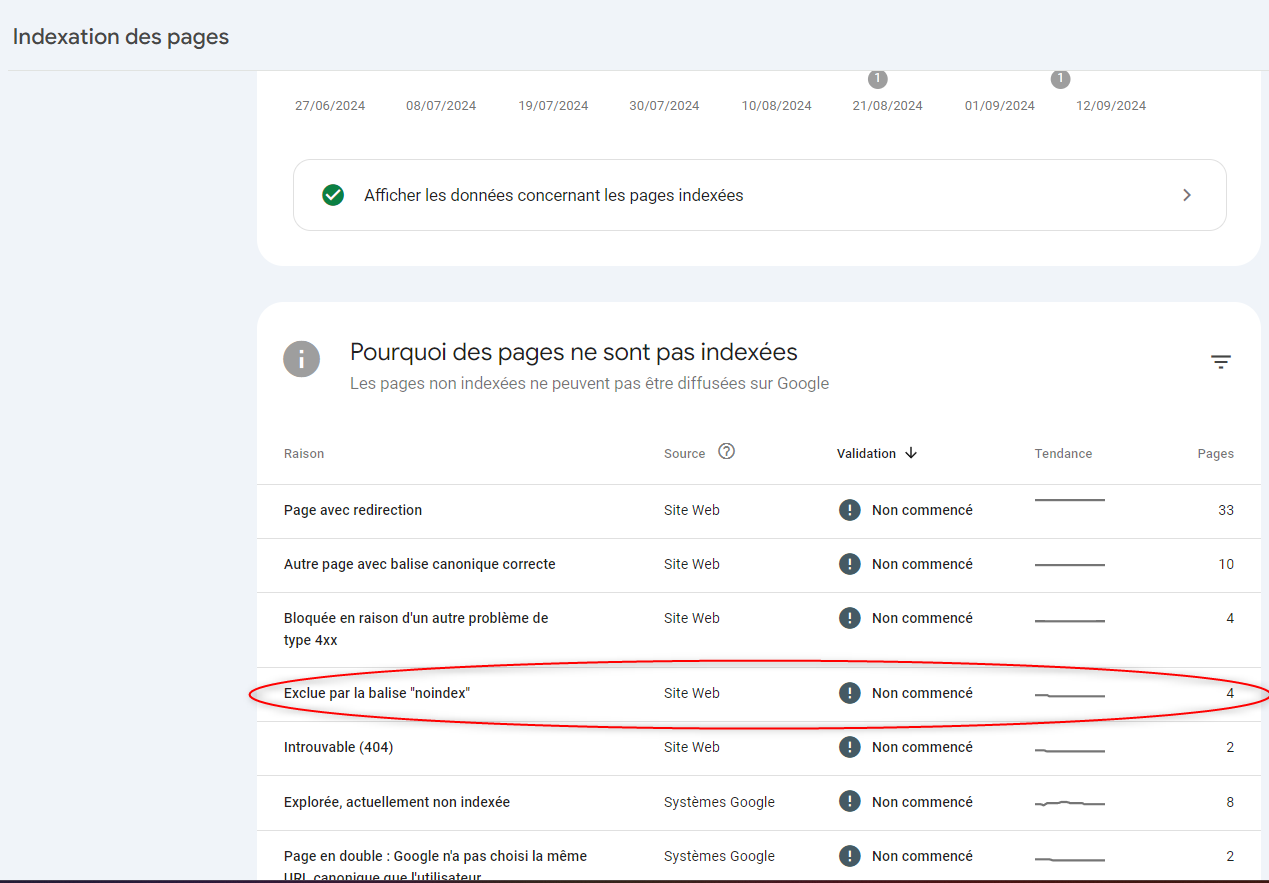

Google Search Console offre également une fonctionnalité d'inspection d'URL. Tapez l'URL de la page dans la barre de recherche de l'outil et vérifiez si elle est marquée comme non indexée. Cet outil vous indiquera si une balise noindex empêche l'indexation de la page.Google Search Console - Pages non indexées

Une autre méthode consiste à aller dans la rubrique "Pages" de la Google Search Console, puis à sélectionner "Indexation des pages". Dans cette section, cochez "non indexées" pour afficher les pages qui ne sont pas indexées, et cherchez celles qui sont exclues par la balise noindex.

3. Synthése :

Vérifiez régulièrement votre fichier robots.txt : Assurez-vous que ce fichier ne bloque pas accidentellement des pages importantes pour le SEO. Il est recommandé de le surveiller régulièrement, surtout après des modifications structurelles sur le site.

Surveillez les balises noindex : Si vous utilisez des balises noindex, assurez-vous qu'elles ne sont appliquées qu'aux pages qui ne nécessitent pas d'être indexées. Utilisez Google Search Console pour identifier les pages exclues par erreur.

Effectuez un audit SEO régulier : Utilisez des outils comme Screaming Frog pour crawler votre site et identifier rapidement les pages qui pourraient ne pas être indexables. Cela vous permet de détecter les problèmes avant qu'ils n'affectent votre SEO.